编者按:西汉刘安的《淮南子·说山训》中有这样一段话:

“见一叶落,而知岁之将暮;睹瓶中之冰,而知天下之寒.”

这两句话显示了人见微而知著的能力,人对这个世界的认知,是在对周围世界的不断探索过程中逐步形成的。从第一次张开双眼观察这个世界,到对这个世界的每一次发问,我们在父母的监督之下成长,整个学习过程也是伴随着外部反馈的大量监督信息。

我们一直试图让机器像人一样学习,因此,在目标检测分类任务中,我们为机器提供了海量的有监督数据,使得机器在某些特定领域甚至取得了远超人类的能力。

然而,对于语义分割任务,大量的像素级别的标注意味着无法想象的人工成本,与之相对应,人对视野内目标的语义分割,也无需以精细到像素级别的监督信息为保障,而只需以弱监督作为辅助。因此,学术界衍生出了针对弱监督的语义分割这一前沿方向。

今天,来自美国伊利诺伊大学香槟分校的魏云超博士,将以一片叶子作为“种子点”出发,带着大家深度学习,直至扩散出整幅图像中秋色的mask。

文末,大讲堂提供文中提到参考文献的下载链接。

本报告主要是针对弱监督视觉语义分割问题来介绍一下近两年来的一些工作。

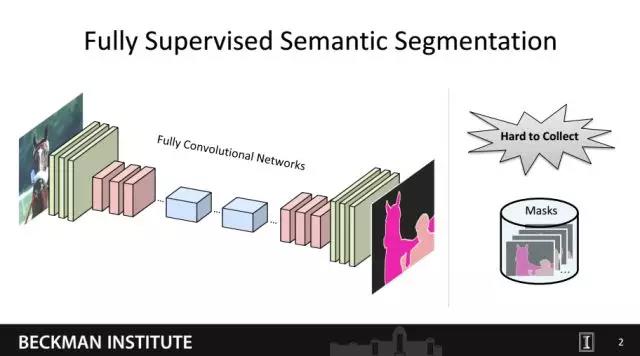

对于语义分割,目前大家用到最多的就是这种全卷积网络。在全监督训练的情况下,我们需要给定训练图片及其对应的像素级标注的mask。然而这种像素级的mask往往很难获取。

比如,我们如果要在ImageNet上做语义分割的话,其标注的工作量会非常大。具体地,ImageNet上大概包括了2万类别,如果每一类我们只标100张图片用于训练的话,最终则需要标二百万的训练图片。如果标注一张图片需要五分钟,则一个人大概需要标注19年才能完成。因此大规模图像的全监督语义分割往往在数据标注上需要耗费大量的时间和金钱。

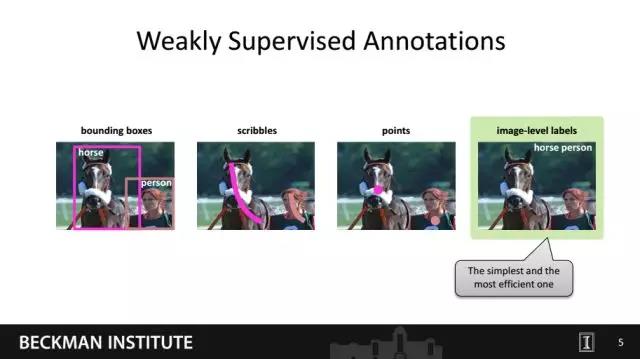

因此我们考虑对于语义分割任务能否采用一些相对于像素级标注更容易获取的标注作为监督信息。这里我们给出了四种简单的标注方式,包括物体框、线条、点以及图像标签。我们称这些比像素级mask更容易获取的监督方式为弱监督。一般来讲,在这些弱监督信息中图像级的标签最容易获取。

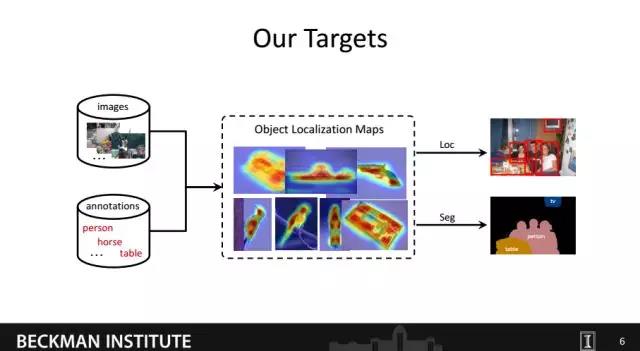

所以我们接下来的工作也都是围绕如何利用图像级的标签作为监督信息,最终实现像素级别的分类。实现这一目标的关键是如何构建训练图像中图像标签和像素之间的关联,即自动的推断出物体在图像中的位置。进而实现弱监督的物体定位或语义分割等任务。

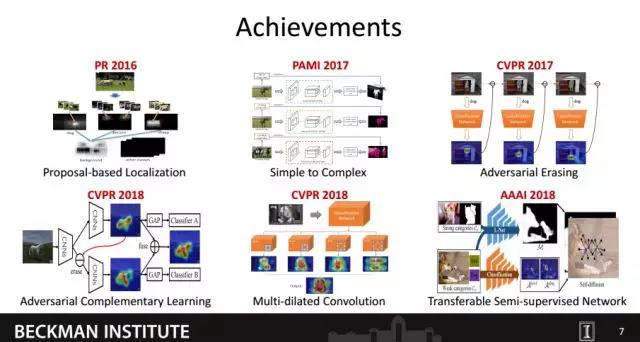

这是我们根据近两年在弱监督学习上的一些工作,主要探索了如何有效构建图像语义标签和像素之间的关联。这些工作在弱(半)监督的语义分割或定位等任务上都取得了当时最好的性能。

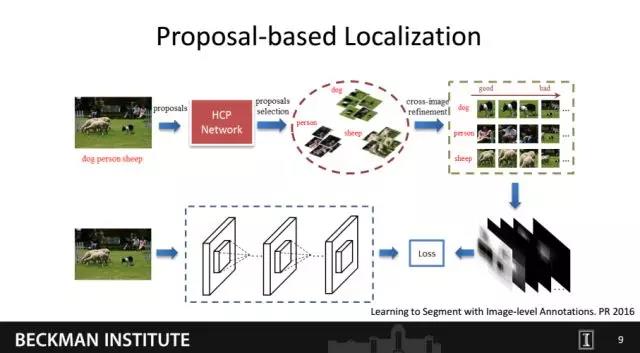

首先是最早在PR上面一篇文章,我们提出了一种Proposal-based的方法来构建图像标签跟语义之间的关联。

这篇文章的思路是训练一个多标签的分类网络,进而利用该网络对图片产生的proposal进行分类,最后将那些在某个类别上confidence比较高的proposal映射回原来的图片,从而获得语义标签和localization的关联。我们利用这种粗糙的localization图作为监督信息训练语义分割网络。

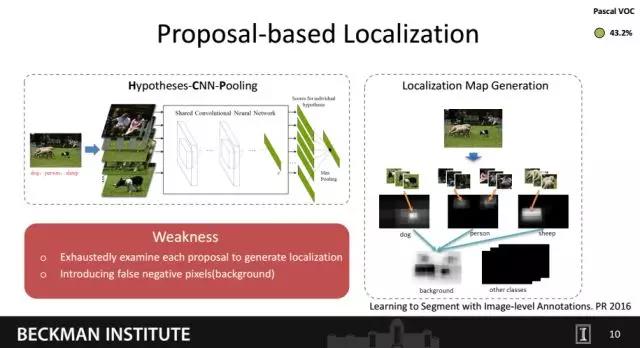

我们利用了当时提出的Hypotheses-CNN-Pooling网络,训练了用于判别proposal类别的分类网络。最后利用那些高confidence的proposal生成物体的定位图。虽然这个工作当时取得了比较高的分割性能,但有两个明显的缺点。首先,该方法需要对所有的proposal都做一次分类,因此会有较高的时耗。其次,直接将proposal内的像素点作为物体区域会引入很多false positive像素,比如属于背景的像素。

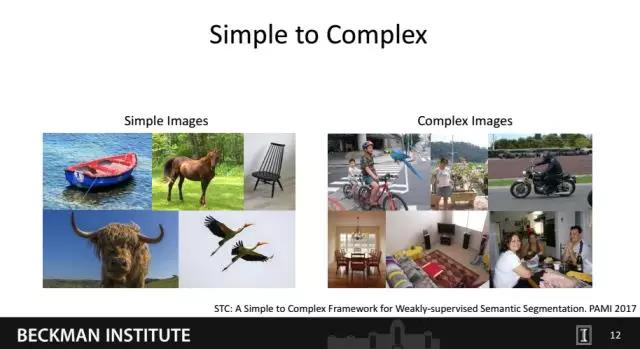

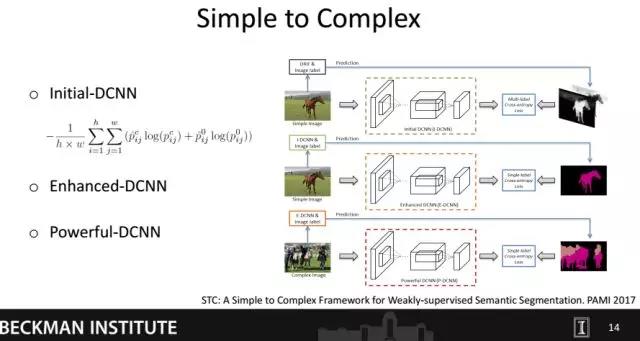

为了克服proposal-based方法的缺点,我们在2017年提出了一种Simple to Complex的方法。

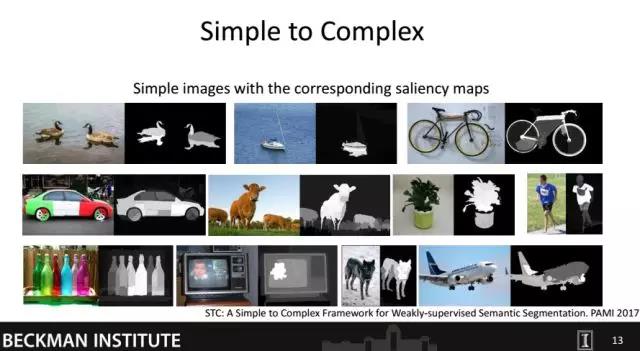

这个方法基于了一个有意思的观察。我们发现Internet上的图片可以大致分为两种,即简单图片和复杂图片。简单图片主要是指图片中的物体类别单一并且背景比较干净;复杂图片主要是指图片中物体类别语义多样并且背景非常杂乱。我们发现对于简单图片,可以通过显著性检测技术有效地获取包含前背景信息显著图。

从上面的图中可以看出,在显著图上像素值越高,其同语义的关联性就越大。因此在知道简单图片语义标签的情况下,我们很容易通过显著图构建语义标签跟像素点的关系。

*博客内容为网友个人发布,仅代表博主个人观点,如有侵权请联系工作人员删除。