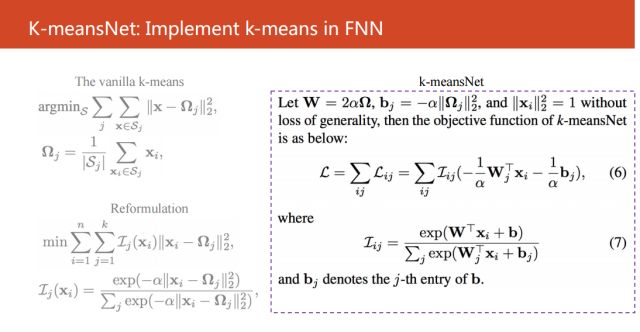

如右图所示的简单变形得到公式(6)和(7),并且我们发现这两个公式是可以等价为一个简洁的前向式神经网络。

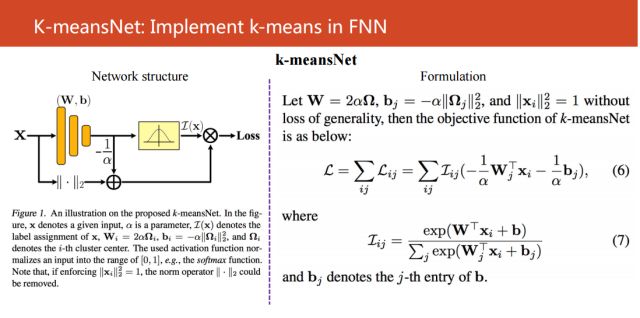

如果大家只看左边的神经网络,大家可能会觉得非常不稀奇,好像就是一个很简单的Sigmoid函数,再加上一个隐含层的神经网络。但是如果结合右边的公式来看,就会发现,这么简单的神经网络是等价于K-means的。

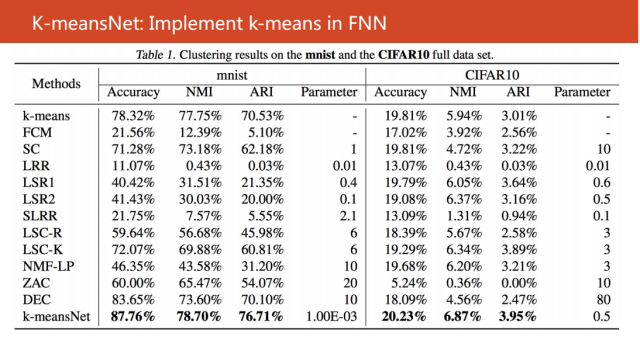

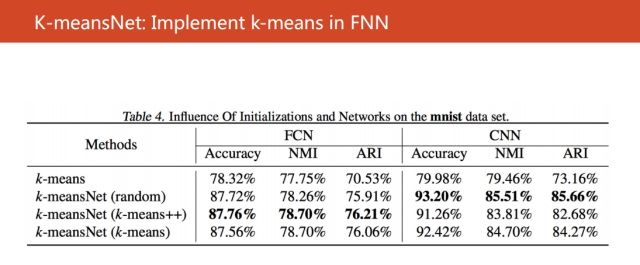

我们在相关的一些数据集上进行验证,比如说我们使用数据mnist和CIFAR10验证神经网络,取得了非常好的效果。

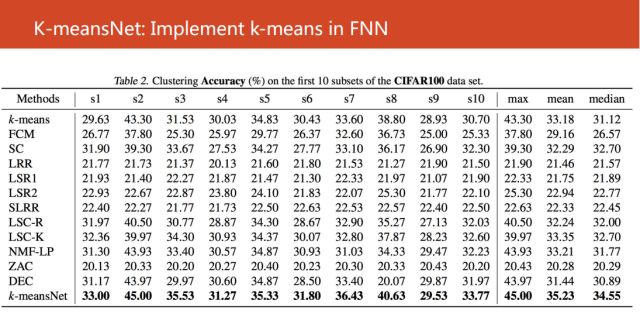

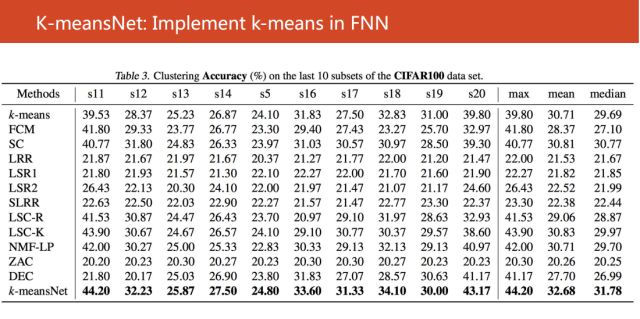

接着我们使用CIFAR100数据的20个子集进行验证,也是取得很不错的结果。

同时我们还考虑使用CNN来发现特征,可以得到超过93%的距离精确度。所以得出一个结论,我们的算法对于距离中心的初始化方法是非常棒的。

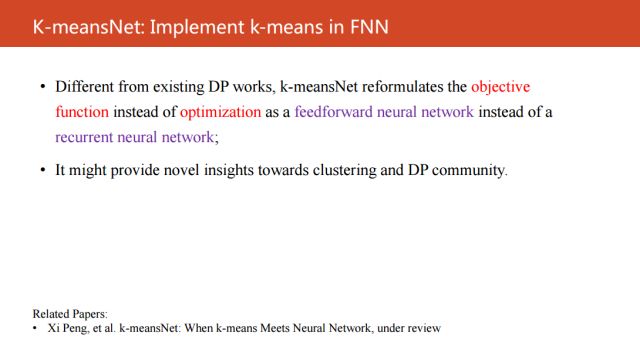

这个工作和现有的可微编程不同主要是两点:

第一,我们的研究思路是从目标出发,而不是从优化过程出发进行研究

第二,我们得到的是前向式神经网络,而不是回复式的神经网络。

接下来给大家分享一下我和我的合作伙伴的一些思考。

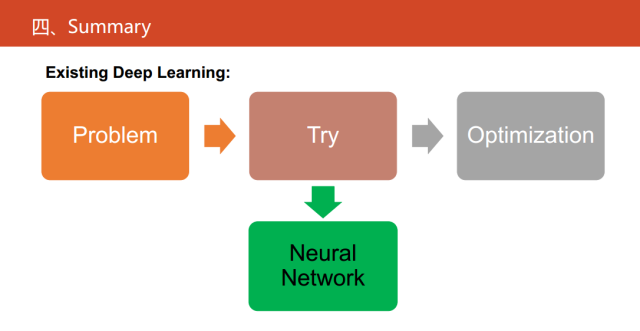

目前,深度学习的研究主要是对通过对一些算法的性能指标不断地试错,最后确定整个网络的结构以及相关的超参,这也是深度学习最为诟病的一点。

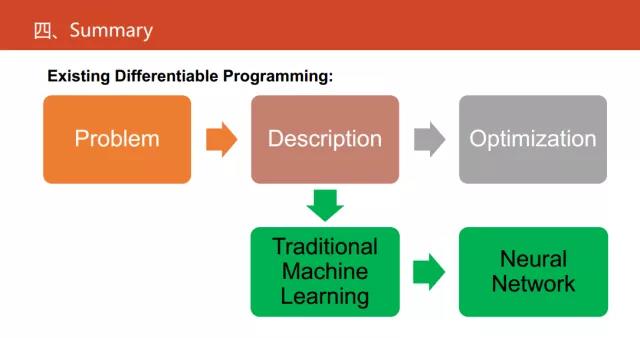

现在深度神经网络已经占据了绝对的优势,可微编程提供了从高解释性的角度去做这件事,它是将神经网络作为一种语言,将传统的算法转化成神经网络以后,一定程度上缓解了一些深度学习的不足。

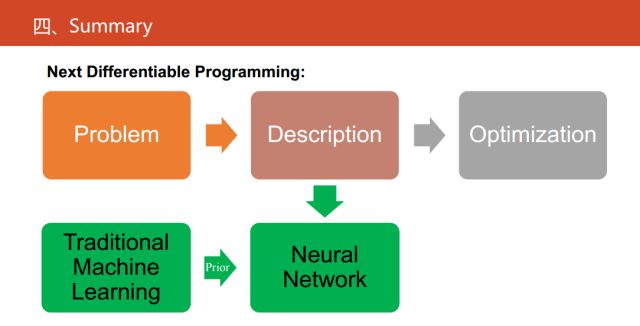

下一步可微编程做什么?现在的可微编程是对传统的继续学习方法的等价或者一种替代物。从问题的描述,再到问题的建模、求解,这是一个很复杂的过程。如果我们对传统的学习的方法,在一定的假设和前提下已经有建好的建模,我们建立等价的神经网络,其实就能走出最容易的一步。

在未来,如果我们真的要贯彻可微编程,就是把它当成一种语言。神经网络应该更进一步,应该直接对问题进行建模,也就是对我们的物理现象进行建模,并且传统的统计机器学习方法有一些先验知识,进而解决我们的一些实际问题。

可能这是更接近于做人工智能这个领域的一个更贴切的思路。

文中提到参考文献的下载链接为:

链接: https://pan.baidu.com/s/18qzJ9PjTb3zR01NDyc_XSQ

密码: vxsi

*博客内容为网友个人发布,仅代表博主个人观点,如有侵权请联系工作人员删除。