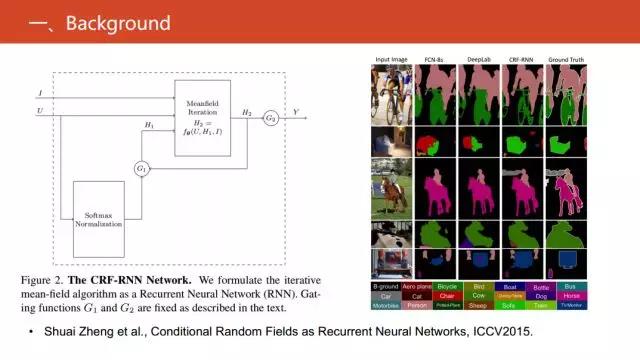

另外,在2015的ICCV上《Conditional Random Fields as Recurrent Neural Networks》文章中提出,把条件随机场的求解变形成了循环神经网络的相关运算,在图像语义分割上实现了突破。

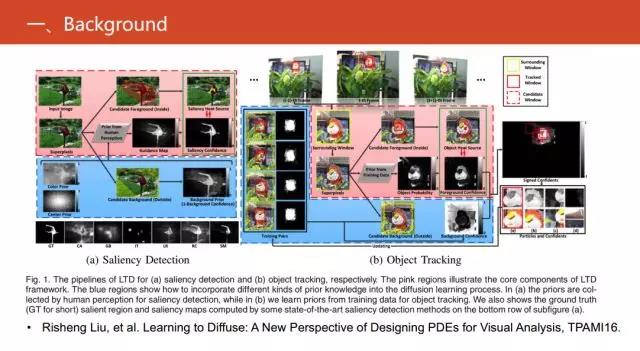

在2016的TPAMI上《Learning to Diffuse: A New Perspective of Designing PDEs for Visual Analysis》文章中,提出的PDE工作在多个任务视觉上取得很好的效果。

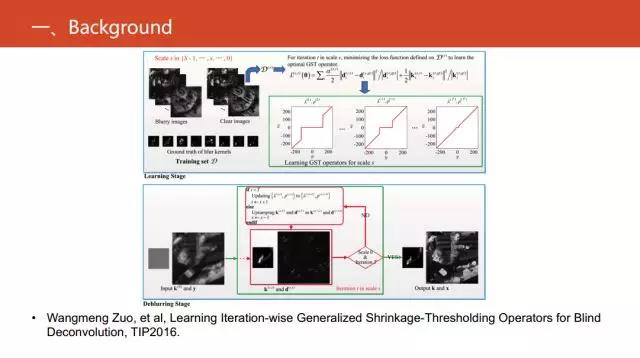

在2016的TIP《Learning Iteration-wise Generalized Shrinkage-Thresholding Operators for Blind Deconvolution》里,针对盲卷积这个问题,发展出能够实现稀疏编码的回复神经网络。

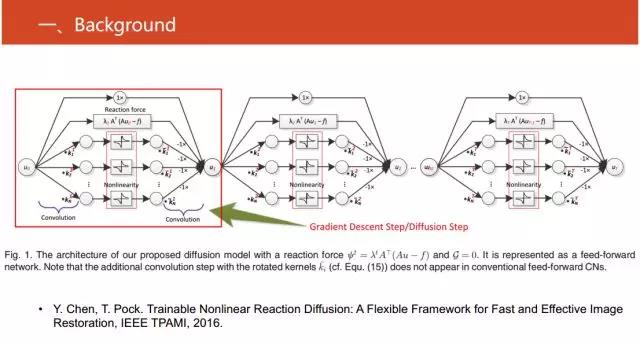

在2016的IEEE TPAMI的《Trainable Nonlinear Reaction Diffusion: A Flexible Framework for Fast and Effective Image Restoration》文章中,对图像重构工作进行了这方面研究。

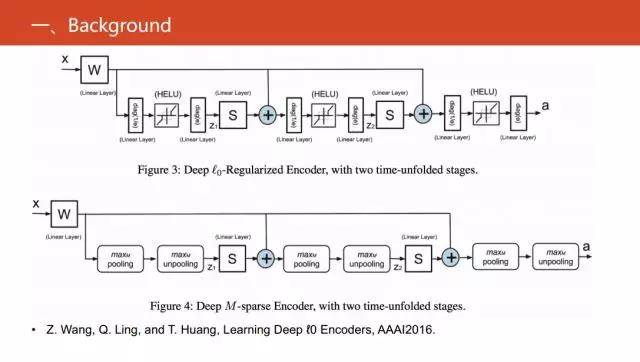

在2016年的AAAI文章《Learning Deep ℓ0 Encoders》中对0范数的优化问题,进行变形和等价建议的回复式神经网络。

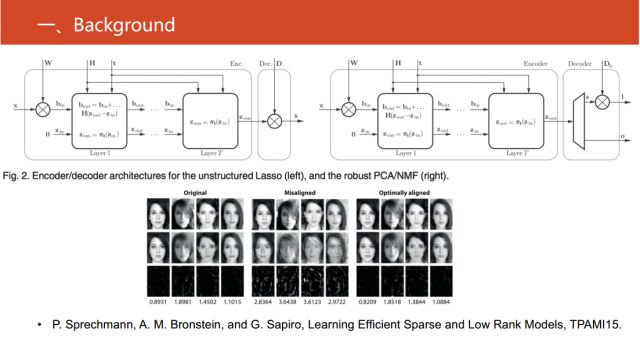

在2015年TPAMI文章《Learning Efficient Sparse and Low Rank Models》中,对使用深度神经网络来实现稀疏模型和非负矩阵分解之间建模的回复式神经网络。

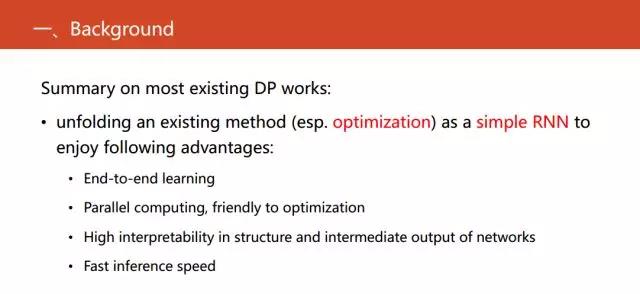

将这些研究进行归纳总结,就是把一些现有的统计机器学习方法,特别是现有的优化过程展开,形成一个简单的神经网络,且其中大多都是一个简单的回复式神经网络。从而使它能享有传统机器学习的优点,比如端到端学习,同时兼具易于优化以及高可解释性等优点。

我相信这样介绍大家可以有一个直观的概念。目前可微编程就是对传统的机器学习的一个逆向的过程,由于传统的机器学习的结构非常清晰,对逆向过程可以产生的神经网络,就可以知道哪一个激活函数的作用是什么,每一层的输出、目的是什么,这也是现有的深度学习方法所不具备的优势。

下面给大家介绍一下我们的第一个工作。我们这项工作从可微编程出发,来研究稀疏编码的优化方法—ISTA 。

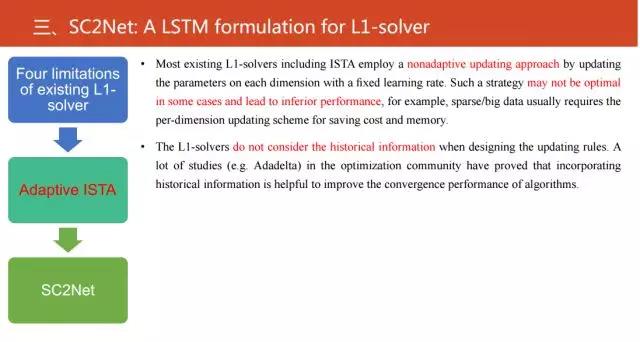

目前,常见的对L1范数优化的方法具有四个局限性:

第一,在优化过程中,对于每一个变量的更新都是采用固定的学习率。所以没有考虑优化变量的每个维度之间的不同。

第二, 这些优化过程并没有考虑历史信息。但是在优化这个研究邻域里已经有大量的工作证明如果考虑历史信息,能够加速算法的收敛。

基于这两点不足,我们提出了自适应的ISTA算法。

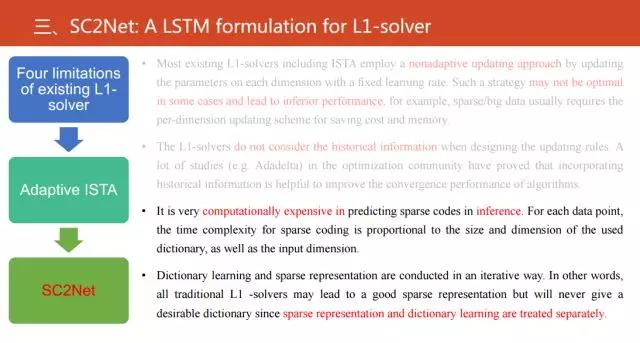

还有两个不足是什么呢?

第三,在稀疏编码推理过程中,计算代价很高。

第四,稀疏表示矩阵计算和字典学习是两个分隔开的步骤。但现在流行端到端的训练,也就是同时优化步骤,这样做可能会产生次优的解。

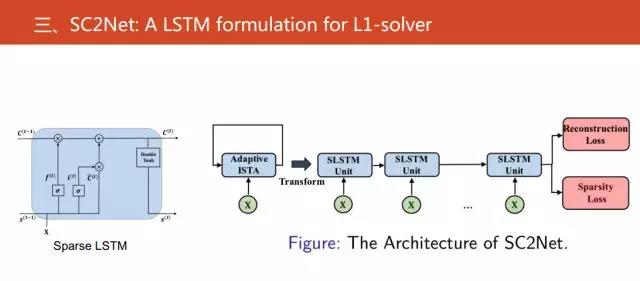

而这两个不足,正好是可微编程能够克服的问题。因此基于这些问题,我们对自适应的ISTA变形和展开提出新的神经网络——SC2Net。

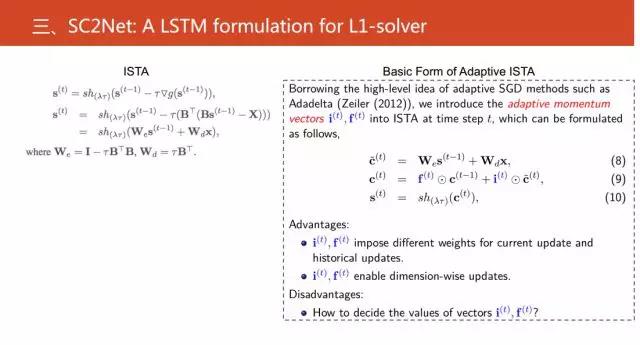

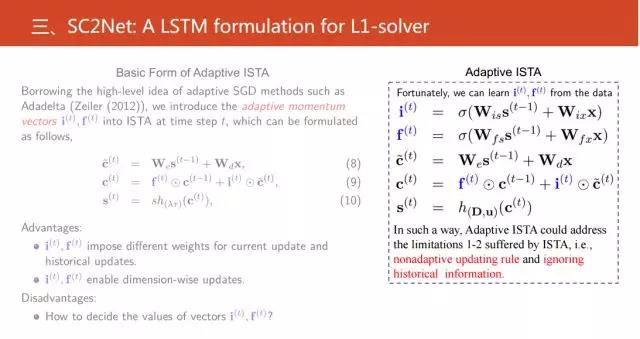

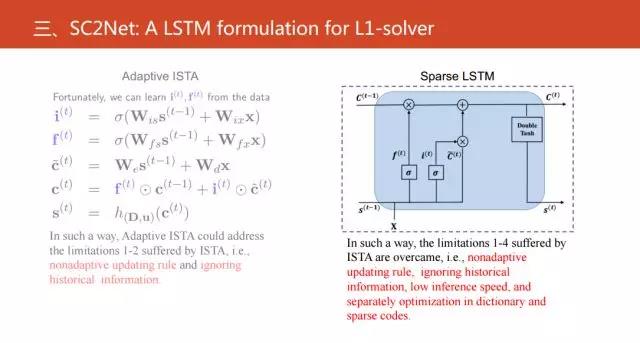

左边是ISTA的关键的优化步骤,基于此,我们引进了动量向量(i(t),f(t))。这就是标准的受益于现代的优化的一些相关的方法,通过引入这两个量,从而解决非自适应更新问题和没有考虑历史信息的不足。更进一步来看,这里存在一个问题,i(t),f(t)如果是两个向量的话,只能确定它的值。使用传统的机器学习方法进行训练,我们人为指定它的值。在研究中,发现可以把这两个向量当成两个变量从数据中学习,就产生了我们提出的自适应ISTA。

同时,我们还发现这种自适应ISTA可以等价于新的长短期记忆神经网络。具体来看,我们可以认为i和f是等价于LSTM中的input gate 和output gate。但是需要注意的是,和经典的LSTM相比,自适应的ISTA是没有output gate。

基于以上,我们就组建了Sparse LSTM,并且构建了相应的神经网络结构。

*博客内容为网友个人发布,仅代表博主个人观点,如有侵权请联系工作人员删除。