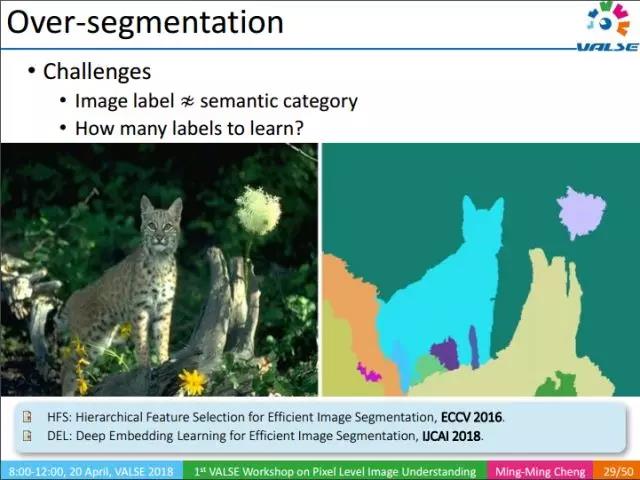

好的过分割结果,能够有效的辅助像素级语义理解(特别是在人工标注数据少的情况下)。过分割(over segmentation)也是一种重要的类别无关的信息,上图的过分割结果虽然形似语义分割(semantic segmentation),但又有本质的区域。在语义分割中,每一个像素都有明确的语义标签,因此我们可以通过神经网络去学习每个像素具体的语义信息。而过分割只是将图像划分成很多不同的区域,每个区域对应一个标签。这些标签没有确定的语义信息,因此给定一幅图像,我们无法确定每个图像能产生多少的区域,也不能确定每个图像能产生多少标签(100, 1000 或1000?),这个问题给学习带来了很多大的困难。下面介绍我们发表在IJCAI2018上的工作。

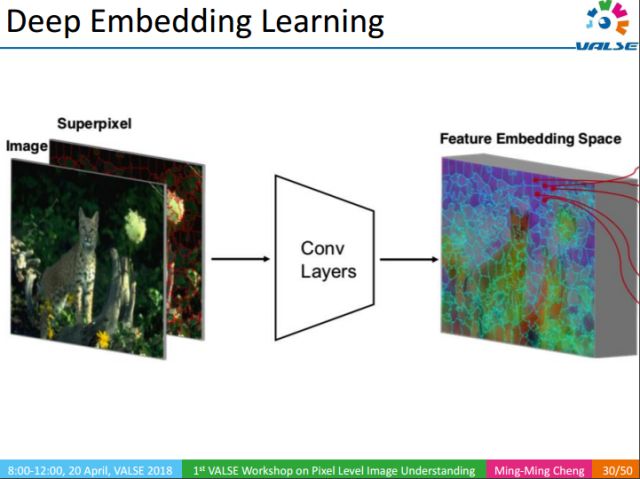

我们的方法并不直接把像素和标注对应起来,而是先将图像进行超像素化,以提高计算速度,然后提取超像素的卷积特征,再将每个超像素的特征pooling为固定长度的向量,最后学习每两个超像素之间的距离。当超像素之间的距离小于一个阈值的时候将其合并(merge)。相比传统方法,我们的方法简单、有效,取得了很好的结果,且能实时处理(50fps/s)。这也给直接从互联网学习像素级语义理解提供了支撑。

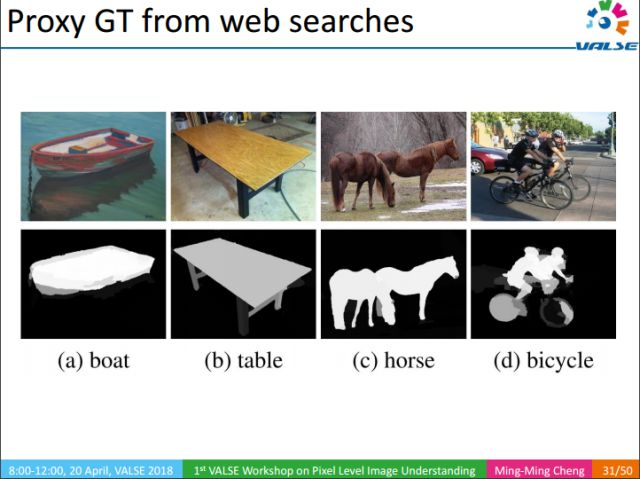

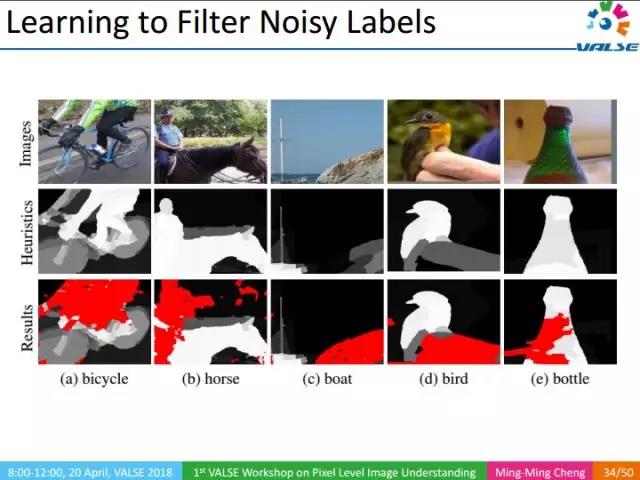

有了上述提到的类别无关的底层视觉知识后,我们可以对图像做很多有意思的分析。例如,我们使用关键词在互联网上检索图像,通过显著性目标检测,可以检测出物体在图像中大概的位置,然后通过边缘、过分割等信息可以进一步精确物体的区域信息。最终可以生成proxy groundtruth(GT),这种GT不是人工标注的,是我们用自动化的方法对互联网图像GT的一种猜测。这种猜测很可能覆盖了关键词在图像中对应的区域,当然这些区域中会存在很多误差。例如对上图中的自行车进行分割时,我们的方法往往把人也标记出来了,因为通常自行车是和人一起出现的。

那么怎么去剔除掉这些误差呢?

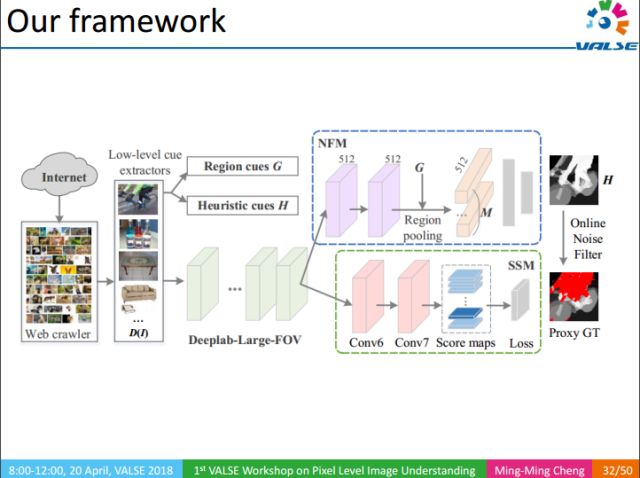

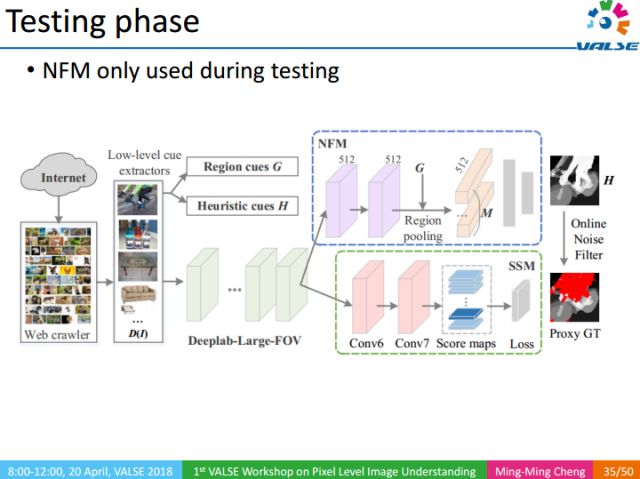

整个方法的流程如下:1利用关键词检索得到大量图像;2利用底层视觉知识,得到图像对应proxy GT;3利用NFM去除proxy GT中的噪声区域对训练过程的影响;4最终通过SSM部分得到语义分割结果。

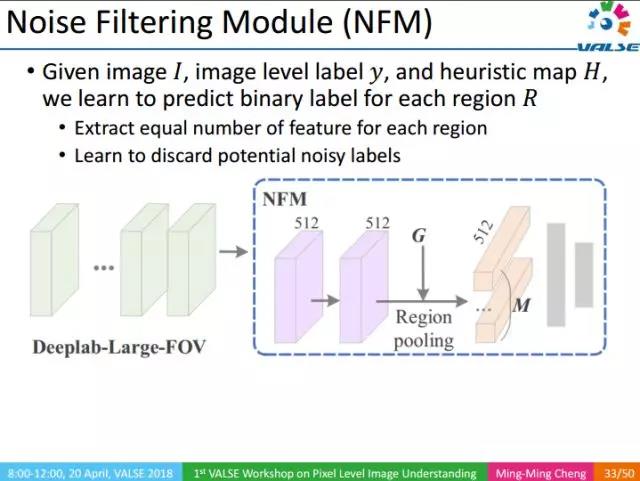

NFM(Noise Filtering Module):噪声滤波模块,给定输入图像,利用图像级的标注以及相应的heuristic map,过滤图像Proxy GT中的噪声区域。

上图中红色区域为识别出来的噪声区域。

NFM作为一种辅助训练的方法,只在测试阶段使用。

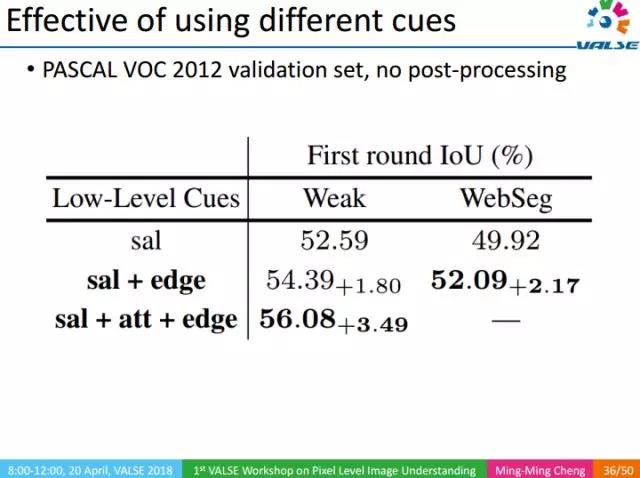

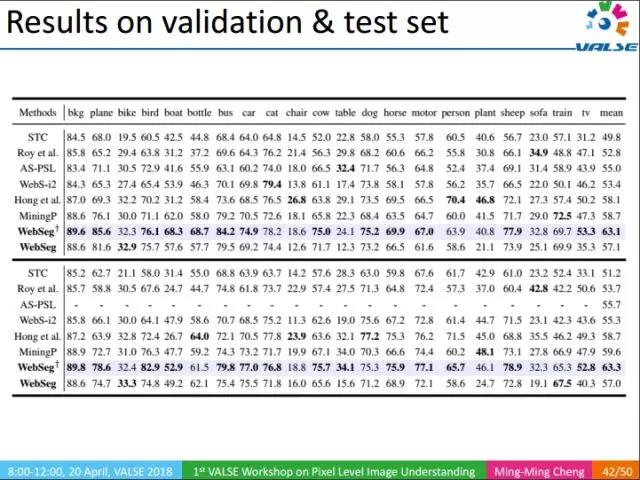

我们通过实验,分别验证了底层视觉知识的重要性。实验分为两类,Weak表示图像只有一个关键词级别的标注,WebSeg则表示图像没有任何人工标注。实际上,底层视觉知识有很多类,我们这里只展示了3类,分别是Saliency object Detection(sal),Edge,Attention(att)。Attention是一种自顶向下的信息,需要有关键词级别的标注信息,由于WebSeg没有使用任何人工标注,所以在WebSeg的实验中没有attention。

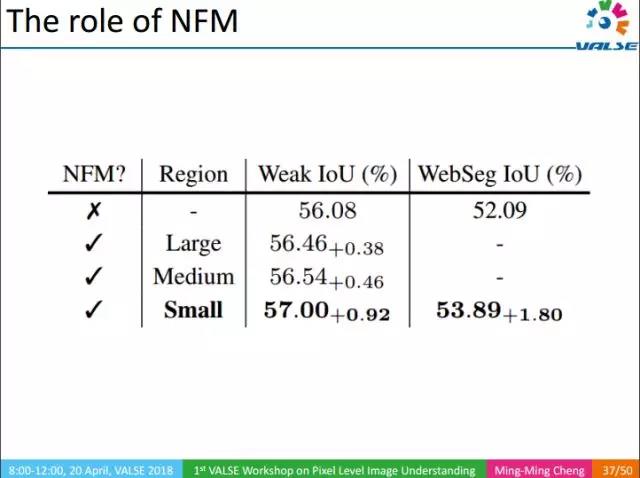

同样,我们还验证了NFM的有效性。可以看出,NMF能够提升IoU准确度。

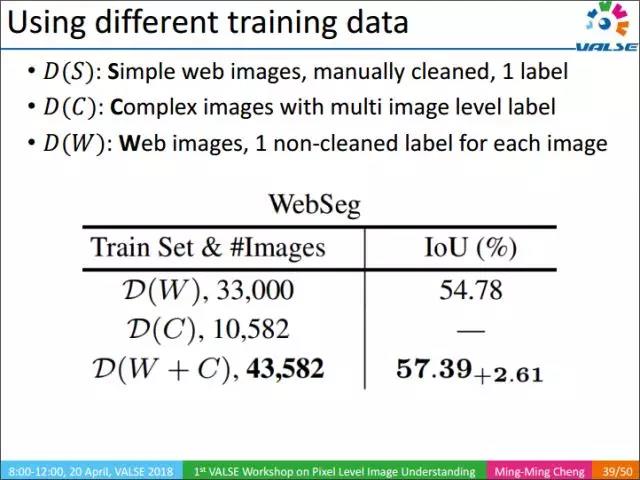

在训练过程中,训练的数据可以分为三类,D(S):图像内容简单,每个图像有一个人工审核过的图像级标注;D(C):图像内容复杂,每个图像有多个审核过的图像级标注;D(W):图像内容不定,每个图像有一个未经审核的标注。

上表中列出了不同训练集组合对应的不同性能。

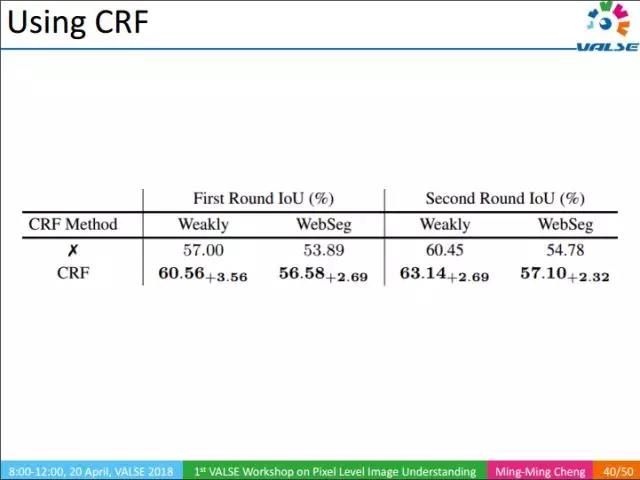

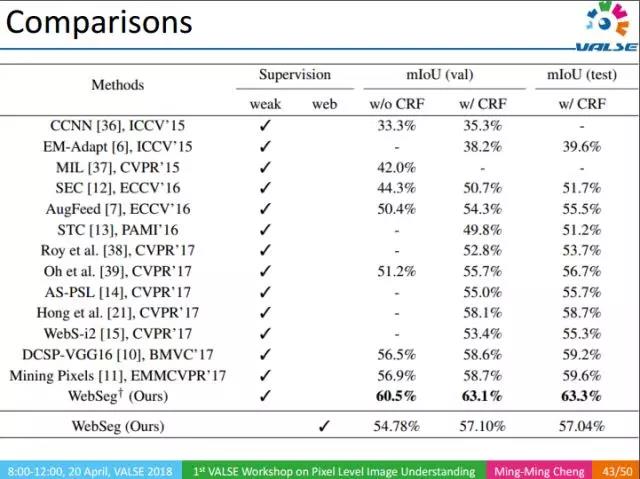

使用CRF能进一步提高结果的精度。

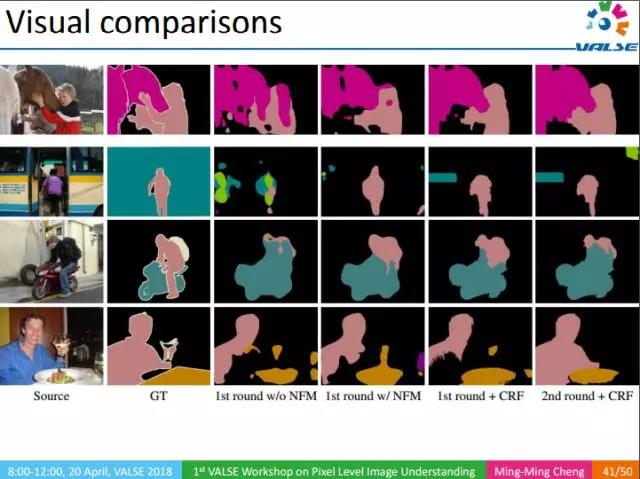

上图是我们的实验结果,从左至右,分别可以看出NFM以及CRF的重要性。总体而言,我们的方法能直接从Web图像中学习并得到很好的语义分割的结果。

上表是在PASCAL 2012上的实验结果,在使用了大量的底层视觉知识后,我们方法平均IOU能达到63%,相比于去年CVPR上最好结果的58%有着很大的提升。

另一很有意义的结果是,在不使用显式人工标注的情况下,我们仍然能取得57%的结果。这一结果实际上超过了CVPR 2017中很多弱监督的方法。事实上,弱监督信息的标注也是很花费时间和精力的,相比而言,我们的方法则无需要任何人工标注。在直接让机器从Web学习像素级语义分割这个方向上,我们只是进行了初步的尝试,但它能在PASCAL VOC这个量级的数据集上能超过CVPR 2017大部分弱监督的结果,是很令人兴奋的。长远来看,这是一个很有意义的研究方向。

总结整个报告,我们提出了一个很有意义且很有挑战性的视觉问题:即在没有人工标注的情况下,怎样直接从Web中学习语义分割。同时我们还提出了一种在线的噪声滤波机制,让CNN学习如何剔除Web学习结果中的噪声区域。整个工作的目的在于:降低或移除像素级语义理解任务对精细标注数据的依赖性。

我们目前只是触及了纯web式监督学习领域的皮毛,后续还有很多值得研究的工作,例如:

1. 怎样把图像有效利用起来,目前的工作,对Web图像不分好坏直接处理,没有做更多的学习,我们要思考是否能够通过学习的方式提升web图像的使用效率;

2. 又或者是否可以把底层视觉知识和其对应的关键词关联起来,如Salient Object Detection,之前是没有与其对应的标注联系起来的,这种相关性能否进一步提升结果?

3. 以及,提升类别无关的底层视觉知识本身的性能,如边缘检测、过分割等;

4. 此外还有其他一些纯粹的Web监督的任务。

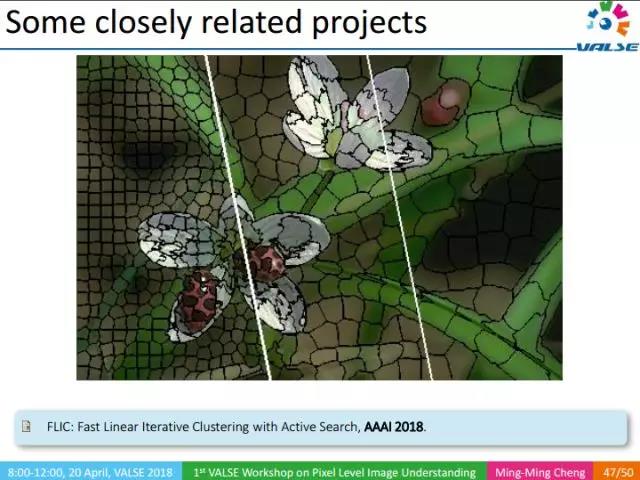

我们还做了许多与底层视觉知识相关的工作,如Over-segmentation。

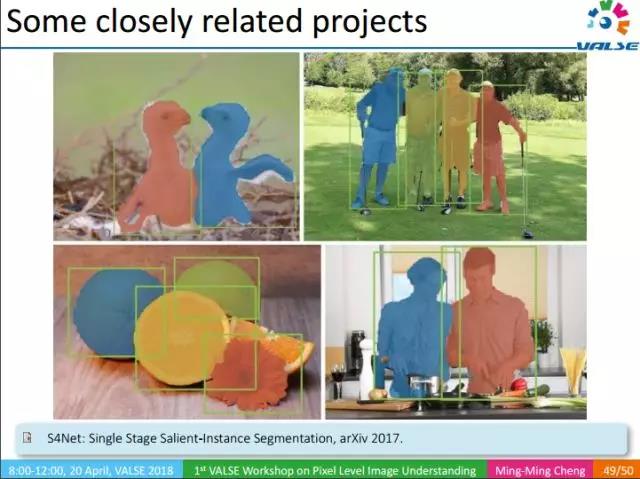

Salient-Instance Segmentation,也是一种类别无关的信息,虽不知道物体类别,但它能把显著的instance分割出来。

另外,我们的工作都有相应的源代码,欢迎大家来使用。

参考文献链接:

https://pan.baidu.com/s/1Qtb11J4lfAw6wscPMMiOGg

密码: d7f3

*博客内容为网友个人发布,仅代表博主个人观点,如有侵权请联系工作人员删除。