基于非线性回归的方法当然就是基于最近比较热的基于深度神经网络的方法。

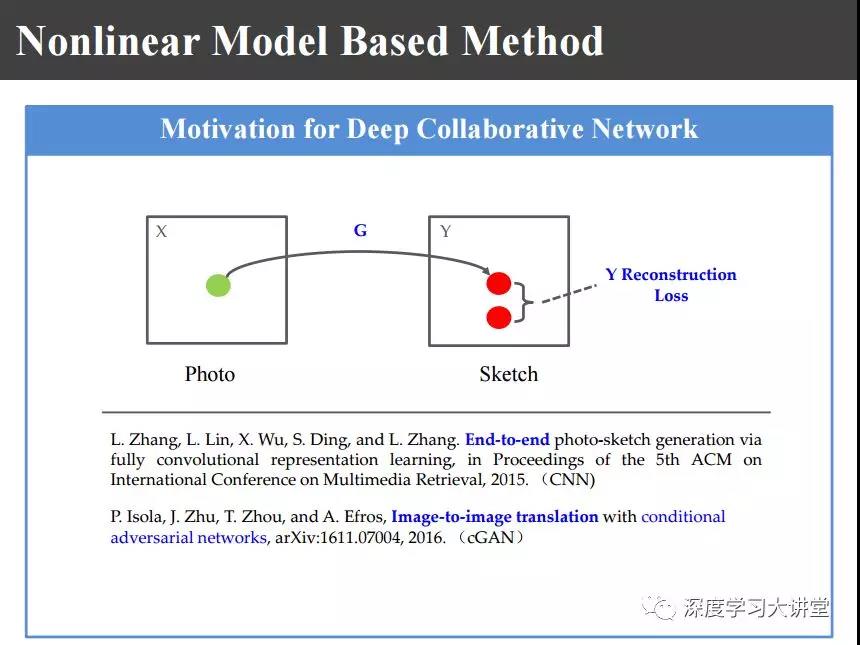

最近,大家都比较熟悉所谓的基于端对端的学习,还有上图基于conditional GAN的方法。不管是照片还是画像,把它映射到另外的异质图像域里,在这个图像域计算它的重建损失reconstruction loss。

后来UC Berkeley的朱俊彦博士提出了上图的CycleGAN,对照片或者图像映射到异质图像域以后再反映射回来,在原始图像域计算Cycle-Consistency Loss。比如,在超分辨重建的时候没有高清图像,在这高分辨域没办法算Loss函数,还要再反映射回来在低分辨域计算它的Loss函数。

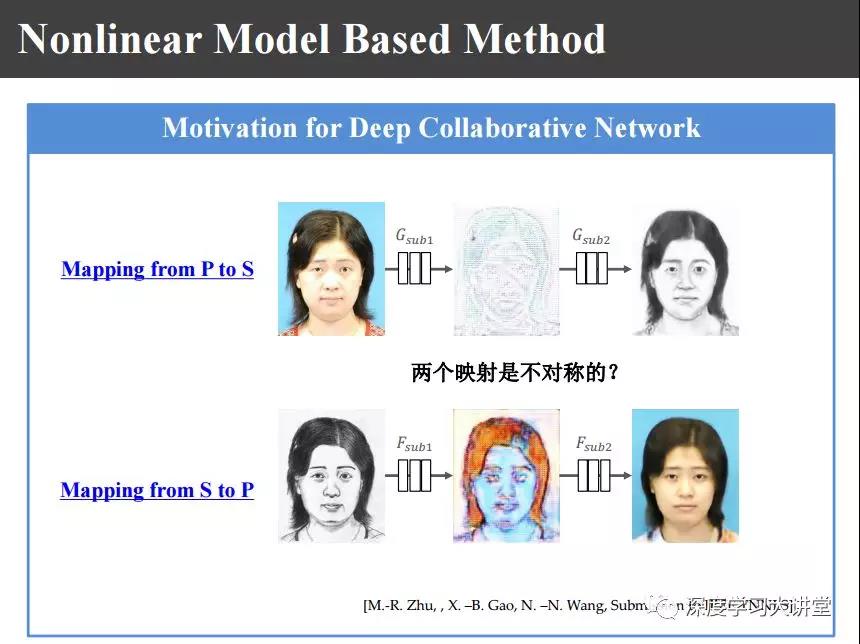

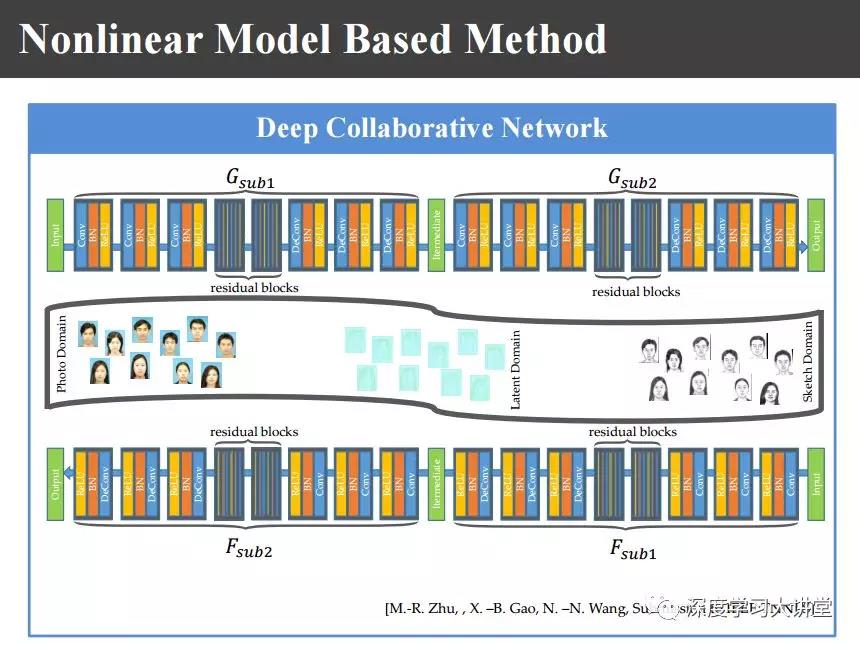

在此基础上我们有上图的考虑,图像正反两个映射是分别单独学习的,从照片到画像学一个,从画像到照片再学一个。那么,这两个映射能不能联合起来一起学习呢?两个映射之间是不是对称的呢?在研究的过程中,上侧是从照片到画像,下侧是从画像到照片,我们把神经网络中间结果拿出来以后发现不是很对称,如果不加约束的话就不是对称的,所以我们就增加一个约束使得它们两个之间能够是对称的,所以就构造下图所示的中间隐空间latent space。

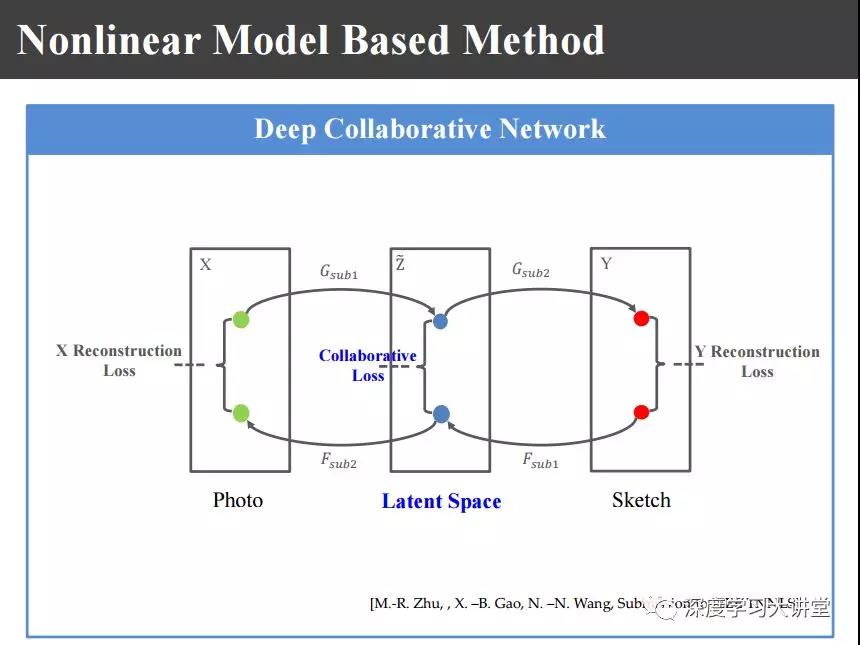

如上图,在这个隐空间里面,原来端到端网络和conditional GAN是在变换空间里面计算它的loss,前面的CycleGAN是在原始空间里面计算loss的,我们希望在隐空间里面计算协同loss。

这样一来我们希望把画像和照片、照片和画像之间两个映射在隐空间里面达到相似,这样一来我们提出上图的深度协同网络。

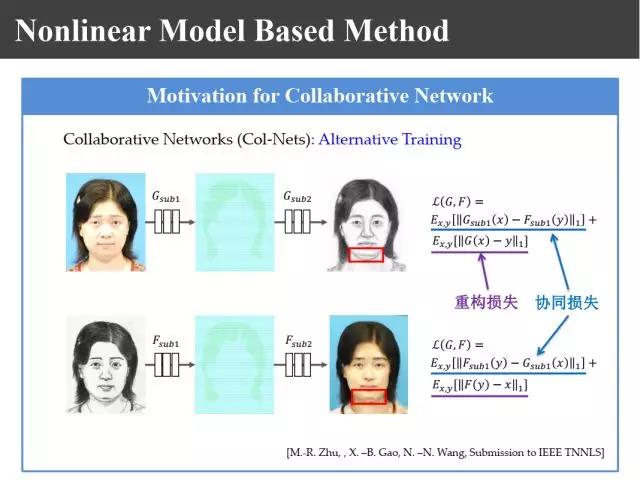

利用深度协同网络使两个映射之间越相似越好,这样就构造上图的重构损失和协同损失,利用两个损失进行约束和优化。

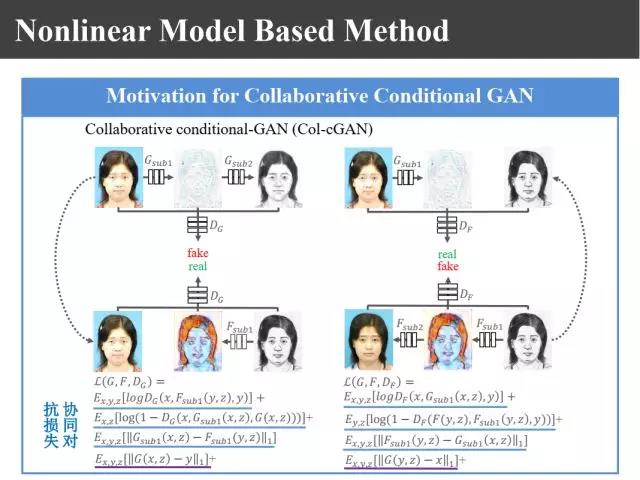

如上图,同样也可以引入GAN,这两个映射G和映射F都可以用生成对抗式网络进行学习。

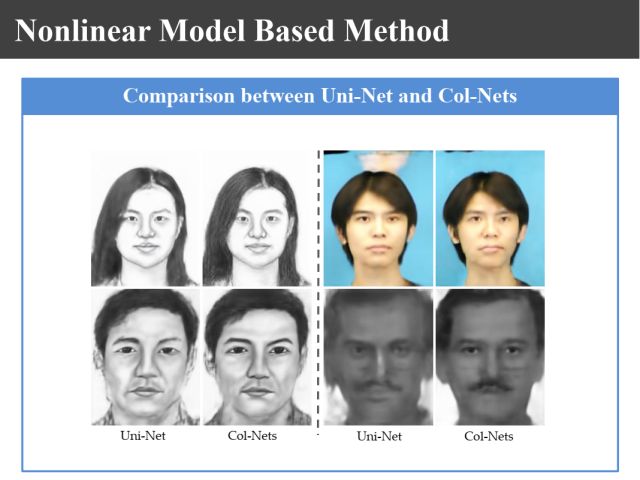

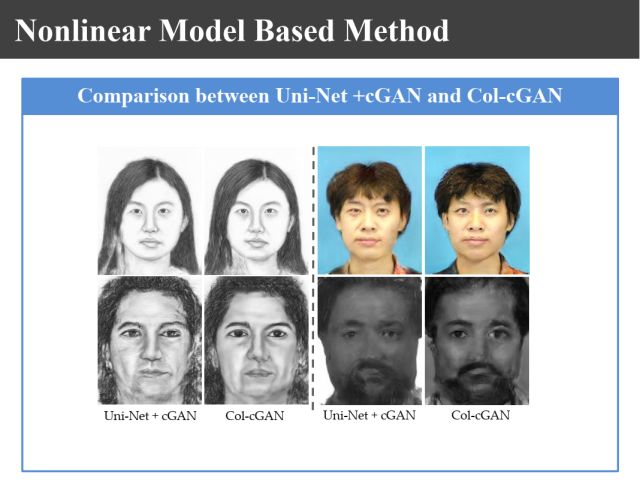

从上面两张图可以发现,通过协同学习比不协同学习合成图像的质量要好的多。

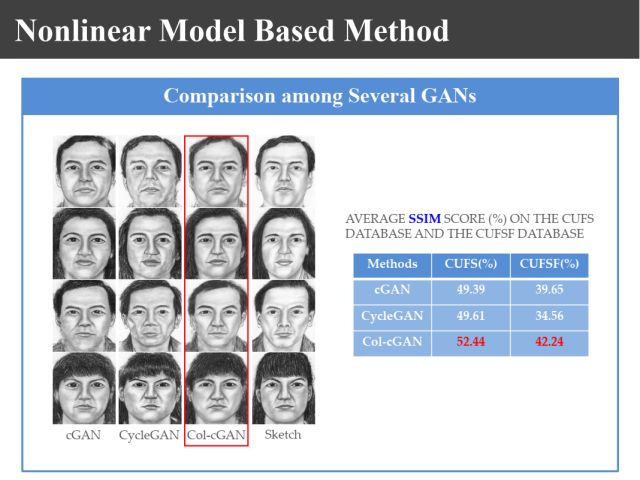

上图是我们基于协同学习得到的实验结果,另外两种都是基于GAN得到的结果。从图像质量评价测度来说,我们这个结果优于他们的结果。

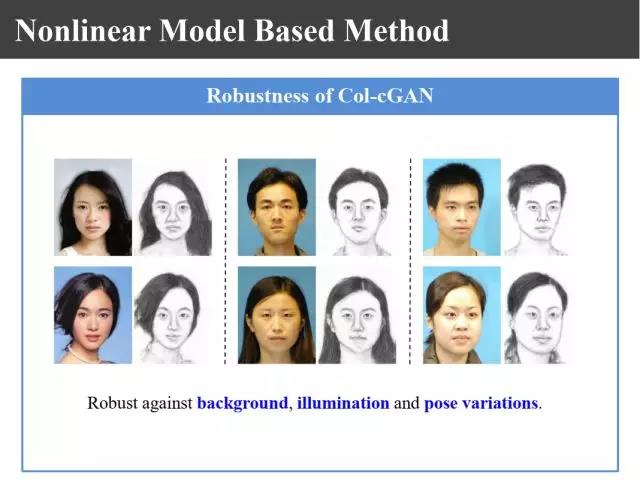

上图展示了我们方法的鲁棒性。通过这个方法它的鲁棒性也非常好,不管是对背景、对光照、对不同姿态都不是那么敏感。

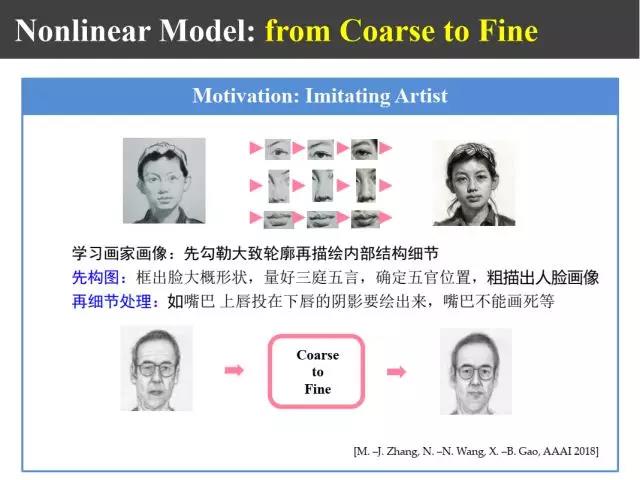

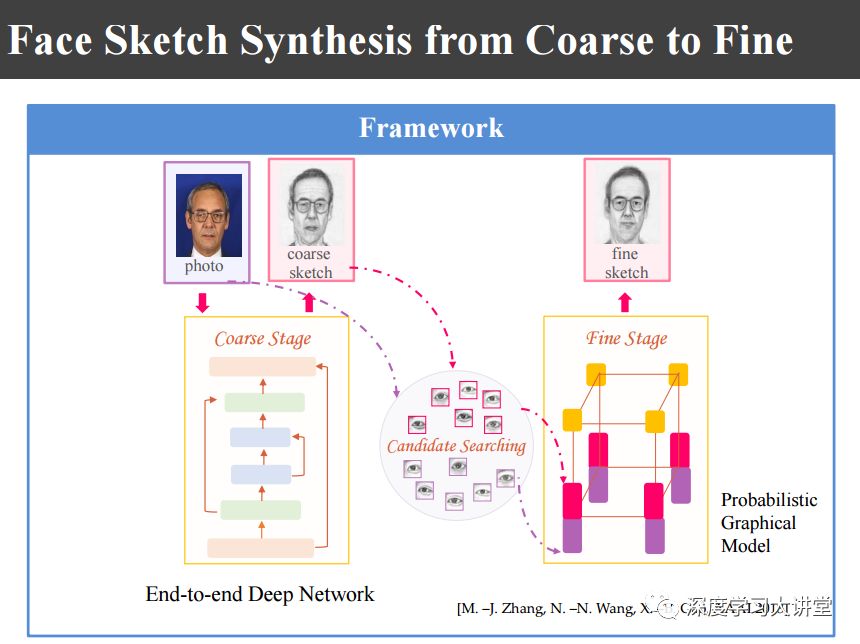

另外我们基于画家画像先画轮廓再画细节的做法,还提出了一种上图中由粗到细的合成方法。

首先利用端对端的GAN学习粗的模型,再利用概率图模型进行细化。

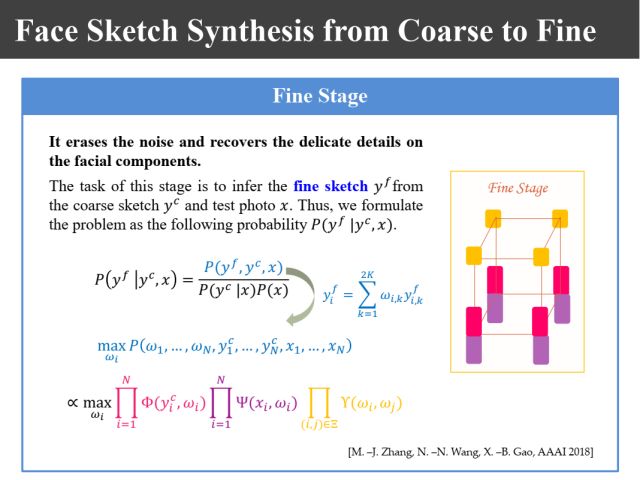

上图是其中涉及到的公式,具体大家可以看我们的相关论文。

其中的精细结构仍然是基于概率图模型来得到的,其核心是似然函数和先验概率的构造。

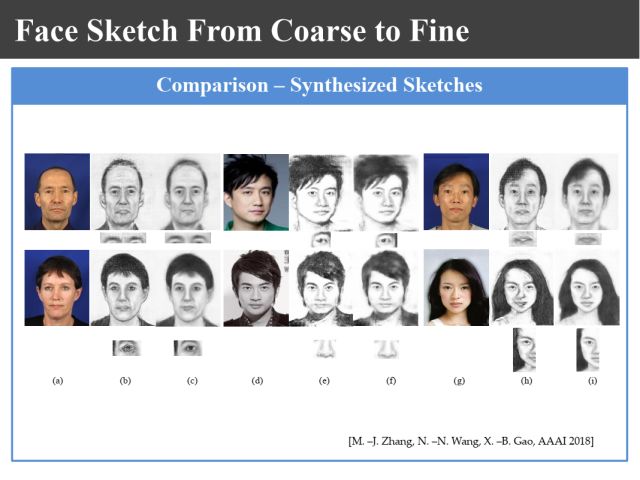

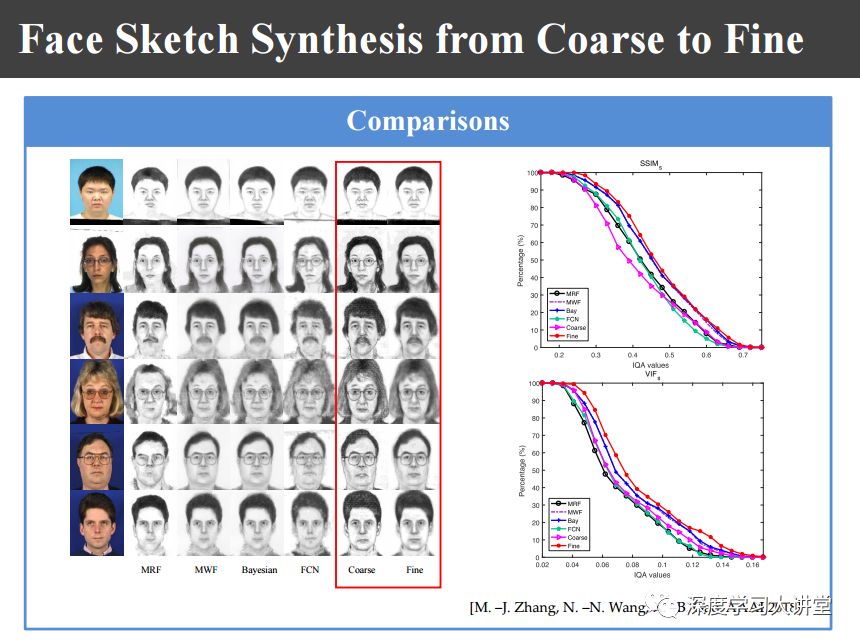

上图是我们生成由粗到细的结果,效果越来越好。

上图是我们和其他方法的对比结果。

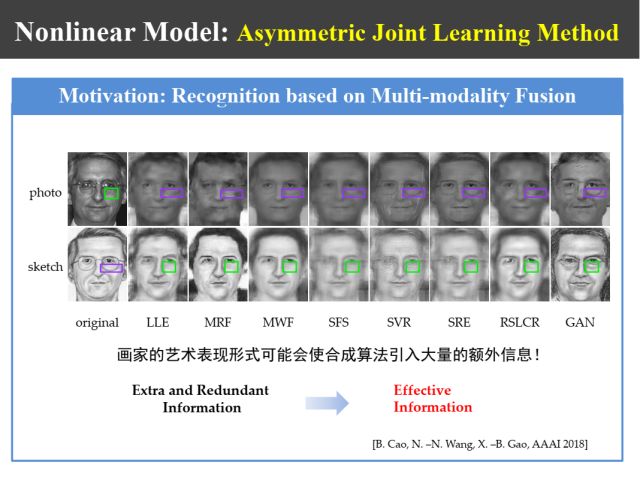

如上图所示,在人脸识别过程中,我们发现不同合成方法都合成出来一些额外信息,而这些额外信息有时候对识别是有用的,可以增加训练样本的多样性。

比如说上图中有些区域,比如说眼袋,不同合成方法合成出来的情况不一样,具有多样性。另外比如说眼镜,眼镜本来没有框,为了画像的效果画家往往会给眼镜画了一个框,合成出来结果有的有框有的没框。那么,如何利用这些额外信息提高模式识别的鲁棒性呢?这为我们的研究提供了新的线索。

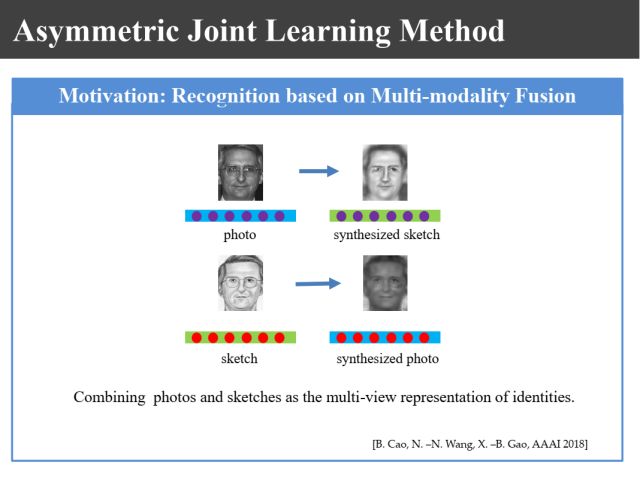

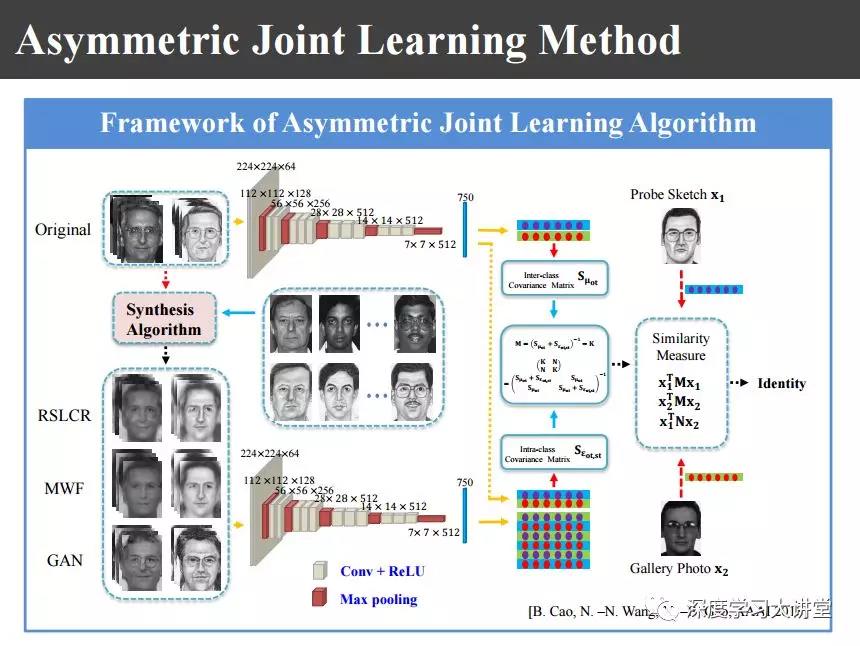

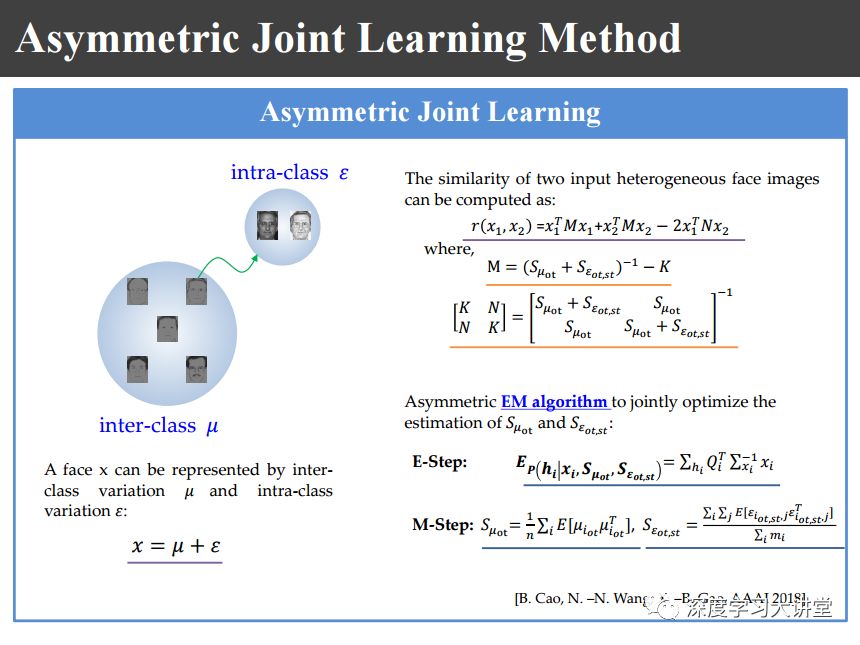

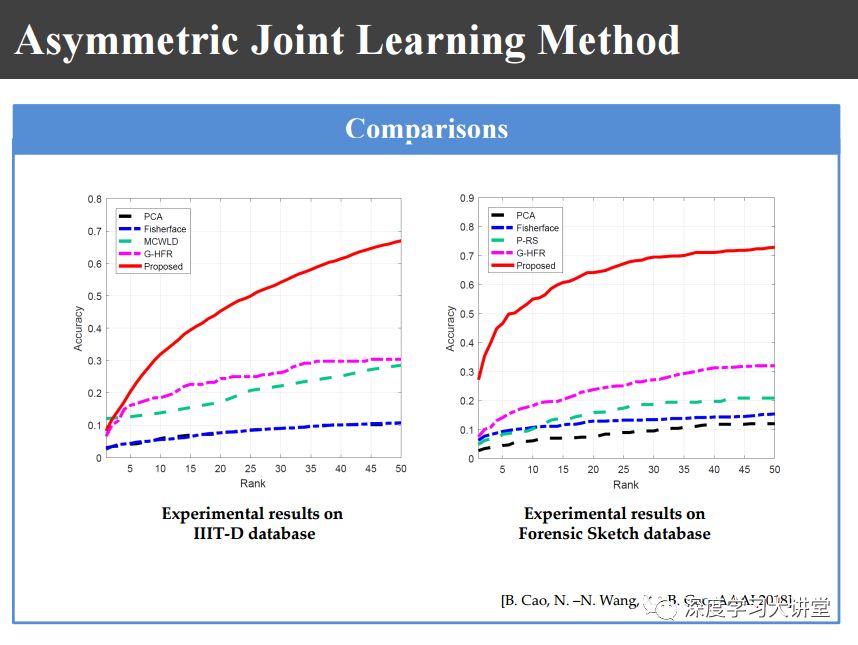

为此我们就提出上图非对称联合学习的识别方法。也就是说,有了照片和画像以后,用不同合成方法都去合成出一些画像和照片来,利用这些信息可以来学习对应不同个体的图像的类内方差,这是为后来的识别服务的。也就是说我的画像和照片对,有了画像和照片数据库以后,把数据库里面的照片和画像都用不同的合成方法合成出一些新的图像对。提完特征以后,利用这些特征提取类间的协方差矩阵和类内的协方差矩阵。类内的协方差主要是因为使用不同的方法合成的,类间的主要还是因为训练不同的数据库里的图像,所以说蛇是一个非对称的学习。

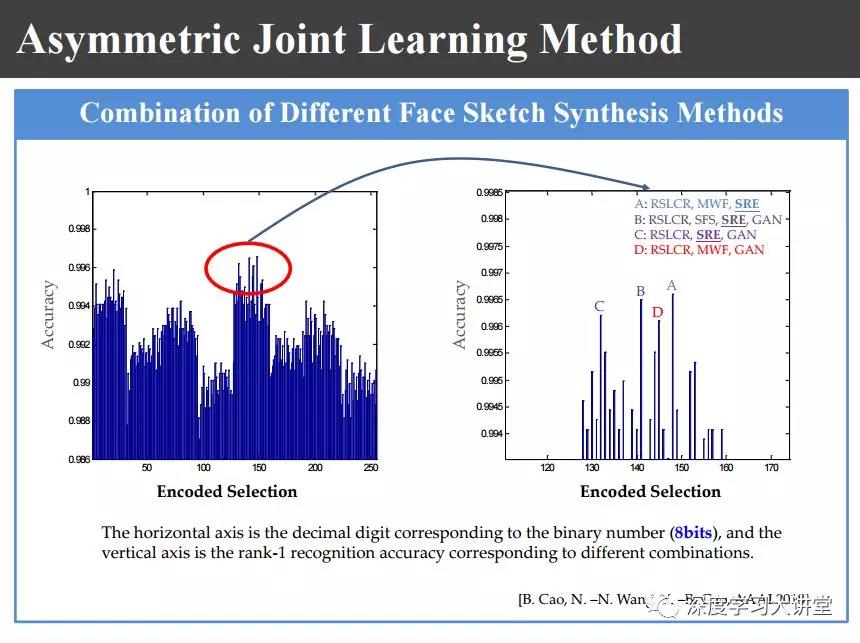

我们有8种图像合成方法,我们分别对这8种用8个二进值数来表示,对所有的256种情况都做了上图的比较,最后选了一种效果不是最好、但是速度最快的方法来进行合成。

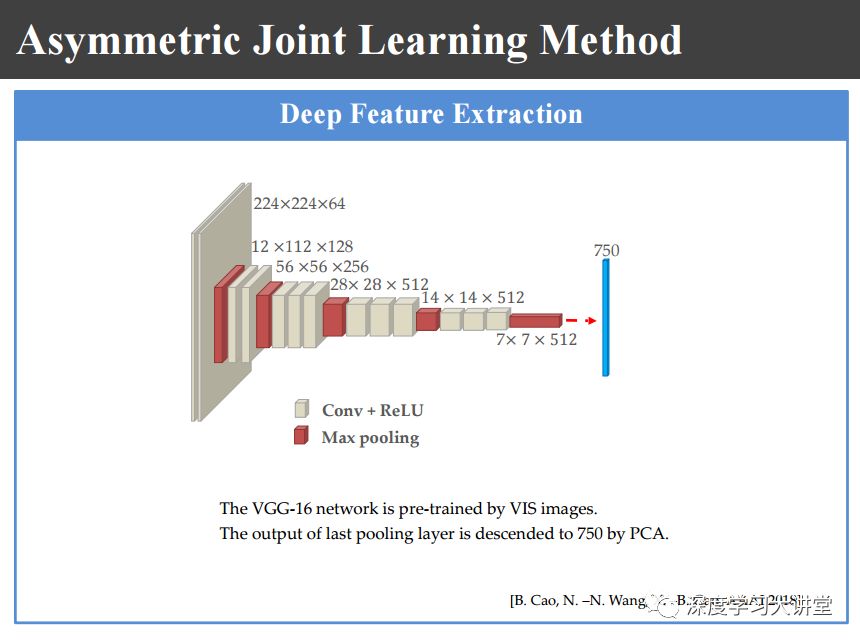

合成以后我们使用上图所示的网络来提取深度特征。

如上图所示,分别计算类间和类内的协方差矩阵,利用这两个协方差矩阵来进行识别。

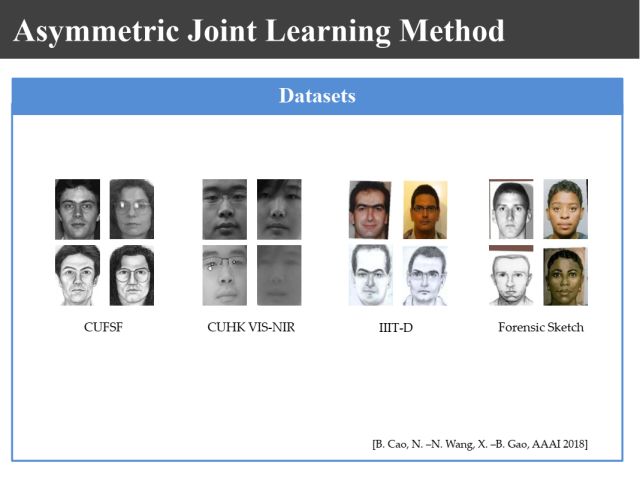

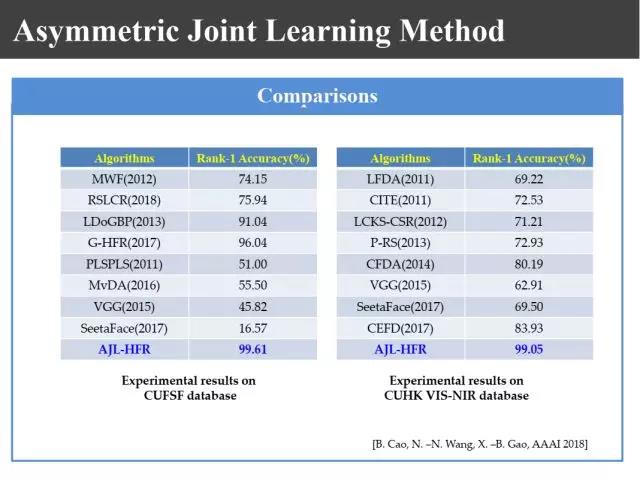

在上图不同数据库上做识别以后,我们现在识别结果在CUFSF数据库上可以达到99.61%,在CUHK VIS-NIR数据库上达到99.05%。

即便是在印度理工的数据库上,过去的识别率是30%,现在可以达到60~70%的结果,这个结果已经是非常好的了。

最后我总结一下。

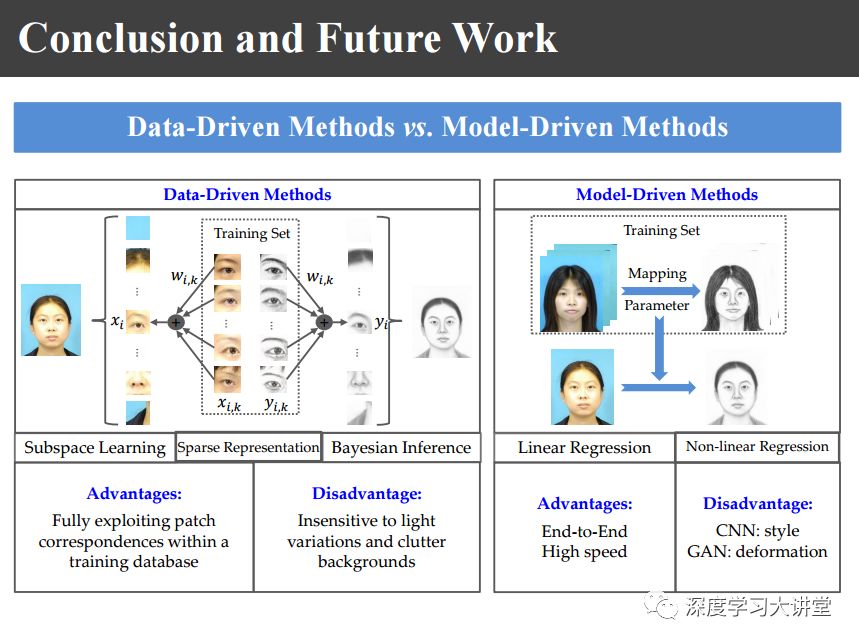

上图系统总结了我们8年以来在异质图像合成方面的工作,主要有data-driven和model-driven两种不同类型的合成方法。

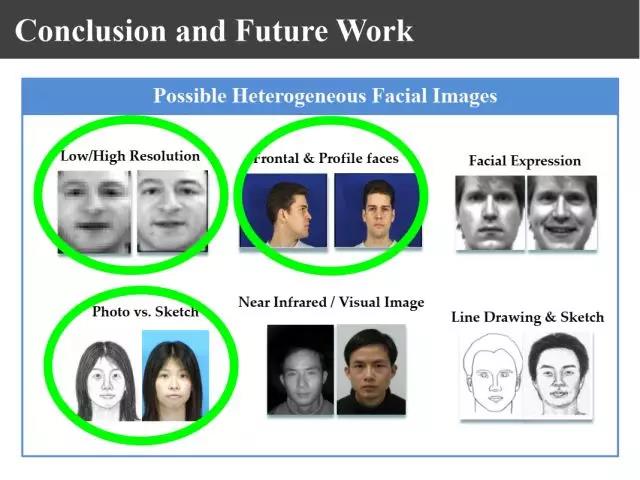

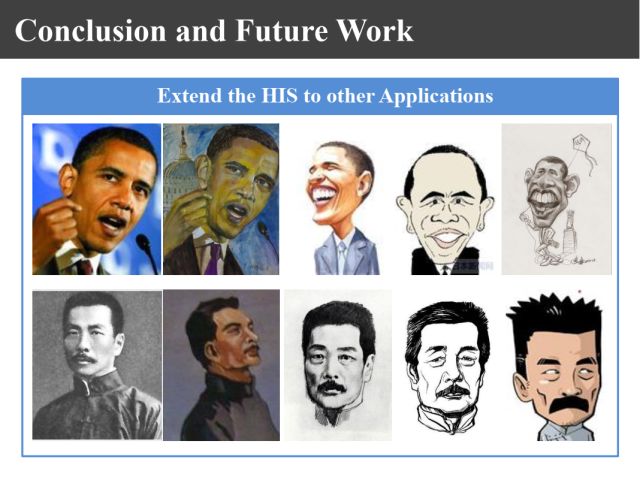

如上图,异质图像不仅仅是画像和照片、低分辨和高分辨、侧面到正面,还有其他的情况,还可以把这些方法进行不断推广。

比如说推广到上图这种情况。上图这些都是异质图像,如果将来能生成油画甚至漫画就更好了。

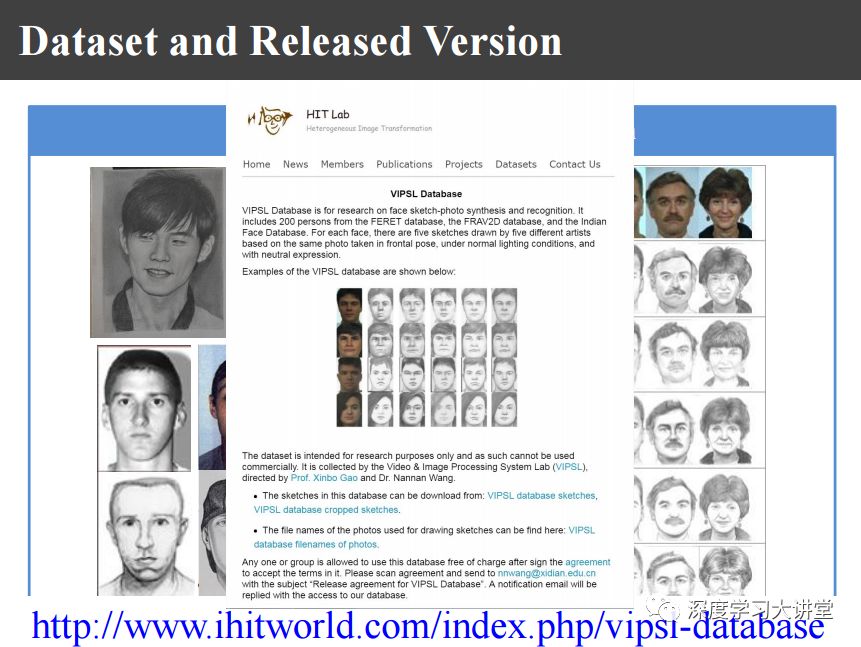

另外相关的数据库也非常难得,有的画像是看着照片画的,也有看一眼之后根据记忆画的,这种就更难了,真实应用的时候都是根据记忆来画的。现在我们找美院学生对不同照片由5个人来画了画像,这个画像已经在网上release。如果大家有兴趣的话,可以到上图的网站上去下载,可以去进行测试。

上述整个工作是我的团队和我一起完成的,团队主要成员有王楠楠副教授,另外还有我的几个博士后、博士生一起完成的,在此一并感谢。

最后谢谢大家。

文中提到参考文献下载链接:

https://pan.baidu.com/s/1pACLck_EcMJBve0NCXNxBA

密码: nv3f

*博客内容为网友个人发布,仅代表博主个人观点,如有侵权请联系工作人员删除。